인공지능

[인공지능] 케라스 학습 기술 - 옵티마이저

범범조조

2022. 2. 17. 20:56

참조

모멘텀 최적화

import tensorflow as tf

from tensorflow.keras.optimizers import SGD

optimizer = SGD(learning_rate = 0.001, monentum=0.9) # 알파 값으로 들어간다.네스테로프(Nesterov)

- 모멘텀의 방향으로 조금 앞선 곳에서 손실함수의 그라디언트를 구함

- 시간이 지날수록 조금 더 빨리 최솟값에 도달

import tensorflow as tf

from tensorflow.keras.optimizers import SGD

optimizer = SGD(learning_rate=0.001, monentum=0.9, nesterov=True) AdaGrad

- 보통 간단한 모델에는 효과 좋을 수는 있으나, 심층 신경망 모델에서는 사용 X

from tensorflow.keras.optimizers import Adagrad

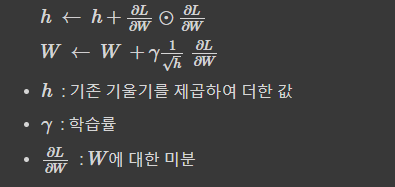

optimizer = Adagrad(learning_rate=0.001)RMSProp

from tensorflow.keras.optimizers import RMSprop

optimizer = RMSprop(learning_rate=0.001, rho=0.9)Adam

- 일반적으로 가장 많이 사용하는 옵티마이저

from tensorflow.keras.optimizers import Adam

optimizer = Adam(learning_rate=0.001, beta_1 = 0.9, beta_2 = 0.999)728x90